MNN Chat手机大模型

类型:通讯社交版本:v0.7.0

大小:45.5MB系统:Android更新:2025-10-11 08:34:06

MNN Chat手机大模型是一款能够在移动设备本地运行人工智能模型的应用程序,用户只需下载相应模型文件并导入软件,即可在手机上离线体验多种厂商的大型语言模型,例如deepseek R1满血版和通义QWQ等,这款工具基于成熟的AI推理引擎构建,让手机也能承载复杂的AI计算任务。

1、首先获取MNN Chat手机大模型的安装包;

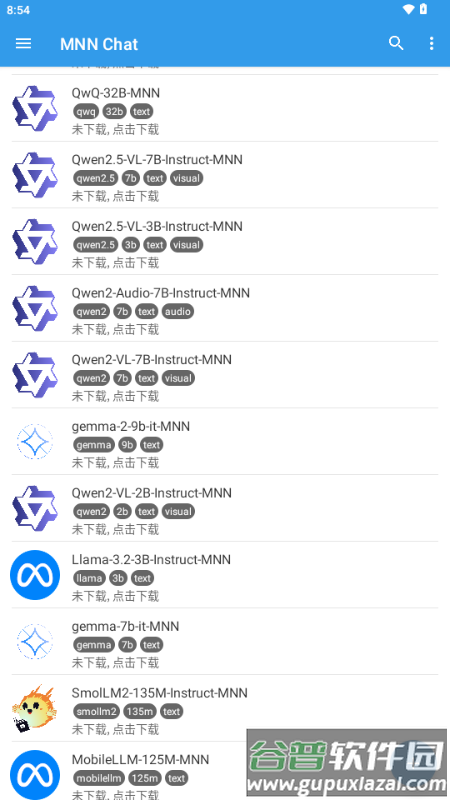

2、打开应用后,从模型库中选择需要部署的AI模型;

3、准备至少10GB的手机存储空间用于模型部署;

4、模型下载完成后即可开始与AI进行对话交流;

5、该应用支持多语言交互,无对话次数限制,所有操作均在本地完成无需网络连接;

完整操作指南可查阅技术文档:https://mnn-docs.readthedocs.io/en/latest/transformers/llm.html

核心推理功能支持CPU与GPU运算,无需额外依赖库,代码结构紧凑,可轻松移植到移动终端及嵌入式设备;

iOS平台完整版静态库约12MB,链接后增加约2MB,精简版可压缩至6.1MB,链接后仅增加600KB;

Android平台主体动态库约800KB,启用Mini编译选项可再缩减25%体积;

支持FP16/Int8模型压缩技术,能减少50%-75%的模型占用空间。

兼容Tensorflow、Caffe、ONNX、Torchscripts等主流模型格式,适配CNN、RNN、GAN、Transformer等网络架构;

支持多输入输出结构,允许可变维度及动态尺寸输入,可运行带控制流的复杂模型;

集成178个Tensorflow算子、52个Caffe算子、163个Torchscipts算子及158个ONNX算子;

覆盖服务器、个人电脑、手机及POSIX嵌入式设备,支持CPU、GPU及部分设备的NPU加速;

运行环境包含Windows、iOS 8.0+、Android 4.3+、Linux等操作系统。

MNN是轻量化深度学习推理引擎,专注于神经网络训练与推理计算,已应用于手机淘宝、手机天猫、优酷等30余款阿里巴巴旗下应用,服务直播、短视频、搜索推荐、图像识别、互动营销、安全风控等业务场景;

MNN-LLM是基于MNN引擎开发的大语言模型本地部署方案,致力于在手机、电脑、嵌入式设备上高效运行千问、百川、智谱、LLAMA等主流语言模型。

针对各平台CPU架构进行深度优化,采用SIMD指令与手写汇编充分发挥算力潜力,单线程运行效率接近设备峰值;

集成Metal、OpenCL、Vulkan移动端GPU加速方案,支持CUDA实现PC端NVIDIA显卡加速推理;

业界首创转置卷积Winograd算法与矩阵乘Strassen算法优化,显著提升运算速度;

支持int8、fp16、bf16低精度计算,针对ARMv8.2与AVX512架构进行指令级优化;

提供数值计算算子覆盖numpy常用功能,内置MNN_CV图像处理模块,支持仿射变换与归一化操作;

支持移动端模型训练与Python调用接口。

LLM功能升级与应用发布;

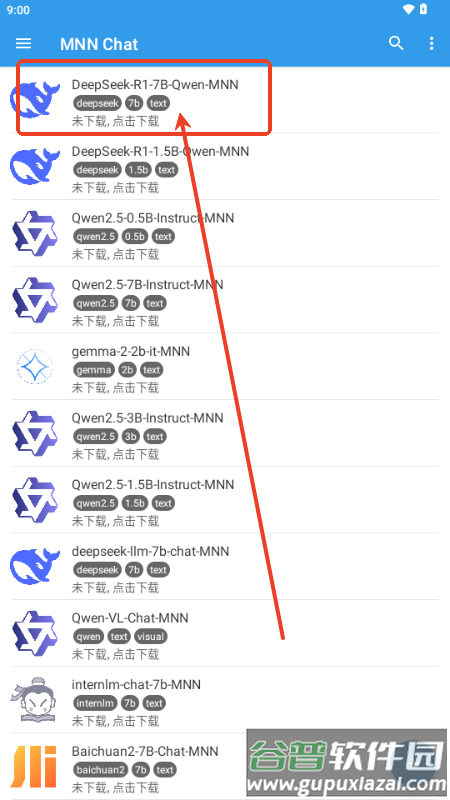

Android平台推出大模型应用;

iOS平台同步上线大模型应用;

新增Qwen2-VL、Qwen2-Audio、Qwen2.5-VL多模态模型导出与运行支持;

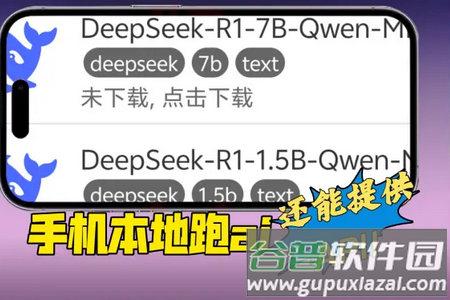

兼容DeepSeek-R1-1.5B-Qwen与DeepSeek-R1-7B-Qwen模型;

LLM单步执行功能便于调试优化;

扩展采样算法增强推理多样性;

模型导出时支持输出历史Token概率数据;

LLM-CPU支持mmap文件缓存加速二次加载;

CPU多线程性能显著提升;

优化CPU prefill性能使1024token与512token输入效率持平;

缩短OpenCL AutoTuning首次推理耗时;

Metal与OpenCL后端支持fp16缩放偏置及对称量化优化;

LLM加速中Metal与OpenCL后端支持fp16格式缩放偏置计算。

包名:com.alibaba.mnnllm.android

MD5:f5822974829f695353008c6cdfcdc897

爱聊免费版

爱聊免费版 v6.1.2 / 108.7 MB查看

2

v6.1.2 / 108.7 MB查看

2 海角社区app

海角社区app v1.0.5 / 127.9 MB查看

3

v1.0.5 / 127.9 MB查看

3 快活视频2024最新版

快活视频2024最新版 v5.9.7 / 169 MB查看

4

v5.9.7 / 169 MB查看

4 OMate安卓版

OMate安卓版 v1.4.7 / 198.36 MB查看

5

v1.4.7 / 198.36 MB查看

5 微信8.0.57下载官方正版

微信8.0.57下载官方正版 v8.0.57 / 246.2 MB查看

6

v8.0.57 / 246.2 MB查看

6 秀秀直播手机版

秀秀直播手机版 v3.0.2 / 125.85 MB查看

7

v3.0.2 / 125.85 MB查看

7 9UU app

9UU app v3.3.8 / 13.6 MB查看

8

v3.3.8 / 13.6 MB查看

8 白日梦ai抢先版

白日梦ai抢先版 v1.0 安卓版 / 6.5 MB查看

9

v1.0 安卓版 / 6.5 MB查看

9 Ant MessengerAPP安卓版

Ant MessengerAPP安卓版 v2.0.31 / 134.25 MB查看

10

v2.0.31 / 134.25 MB查看

10 维密圈app官方版(wei密圈)

维密圈app官方版(wei密圈) v1.15.2 / 73.5 MB查看

v1.15.2 / 73.5 MB查看

最新评论